Teststatistische Merkmale und Normierung

Testversionen

Das Testsystem schreib.on besteht aus zahlreichen Testversionen, die auf jeder Klassenstufe eine mehrfache Testanwendung ohne direkte Testwiederholung ermöglicht.

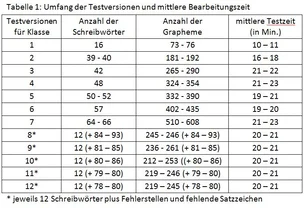

Insgesamt 27 Testversionen stehen zur Verfügung, für die Klassen 1 bis 4 je 3 Versionen, für die Klassen 5 bis 12 je 2 Versionen.

Vergleichsnormen werden jeweils für Mitte und Ende des Schuljahres angeboten, sodass für die 24 Testzeitpunkte insgesamt 56 mögliche Testversionen vorliegen.

Alle schreib.on-Testversionen (mit insgesamt ca. 8.100 Wortstellen) wurden einer Testanalyse unterzogen, in der die üblichen teststatistischen Merkmale (Testumfang, Bearbeitungszeit, Zuverlässigkeit der Testskalen, Gültigkeit des Tests) analysiert und beschrieben wurden.

Durchführung der Testanalyse

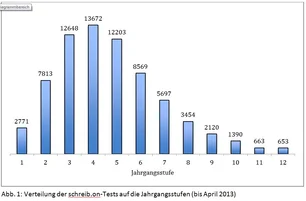

Die Testanalyse bezieht sich auf die insgesamt 71.653 Tests, die bis April 2013 im DIDEON-System durchgeführt wurden und bei denen die Klassenstufe und Schulform der Testpersonen angegeben worden war. Die Verteilung auf die einzelnen Klassenstufen zeigt die folgende Grafik. Der Schwerpunkt liegt eindeutig in den Klassenstufen 3 bis 5.

Umfang der Testversionen

Die Testversionen für die einzelnen Klassenstufen umfassen unterschiedlich viele Schreibwörter. In den Grundschulversionen sind 16 bis 48 Wörter zu schreiben, in den Klassenstufen 5 bis 7 beträgt die Wortanzahl 50 bis 66. Bei den Testversionen ab Klassenstufe 8 müssen 12 vorgegebene Wörter geschrieben und fehlerhafte Wörter korrigiert sowie Satzzeichen ergänzt werden; die Anzahl der zu korrigierenden Wörter bzw. Satzzeichen beträgt zwischen 79 und 93 Einheiten.

BearbeitungszeitenBearbeitungszeiten

Die Zeiten für die Durchführung der Tests werden vom System festgehalten und im Ergebnisprotokoll vermerkt. Die mittleren Bearbeitungszeiten steigen von ca. 10 Minuten in Klasse 1 auf ca. 20 Minuten in den höheren Klassenstufen.

Zusammenhang zwischen Bearbeitungszeit und Testergebnis

Zwischen der vom DIDEON-System registrierten Bearbeitungszeit und dem Test-Gesamtergebnis (Graphemtreffer) beträgt die Korrelation lediglich -0,07. Bei Erstklässlern fällt die Korrelation mit -0,20 am höchsten aus, in der Sekundarstufe beträgt sie lediglich -0,03. Demnach gibt es auf allen Kompetenzniveaus Testpersonen, die den Test eher rasch oder eher langsam bearbeiten. Von der Dauer der Testbearbeitung lässt sich also nicht direkt auf die orthografische Kompetenz schließen.

Schwierigkeit der Testwörter und der strategiebezogenen Wortstellen

Mit der Schwierigkeit einer Testaufgabe ist gemeint, wie viel Prozent der Testpersonen diese Aufgabe richtig lösen. Je höher dieser statistische Wert für die Schwierigkeit ausfällt, desto leichter ist also die Aufgabe. Ein Wert von 100 für die Schwierigkeit besagt, dass alle Testpersonen die Aufgabe richtig gelöst haben.

Beim Rechtschreibtest schreib.on beziehen sich die Angaben zur Test-Schwierigkeit auf die durchschnittlich richtig geschriebenen Wörter, Wortstellen und Satzzeichen.

Der Anteil der Testpersonen, die eine Aufgabe (Wort, Wortstelle, Satzzeichen) korrekt lösen, sollte nach der klassischen Testtheorie möglichst zwischen 10 und 90 Prozent liegen. Ein Anteil unter 10 Prozent bedeutet nämlich, dass die Aufgabe für die Zielgruppe (fast) unlösbar ist. Bei über 90 Prozent Lösungshäufigkeit wird eine Aufgabe (fast) von allen gelöst. In beiden Fällen findet eine Differenzierung zwischen Testpersonen mit unterschiedlichen Fähigkeiten kaum statt. Für eine möglichst hohe Trennschärfe der Aufgaben und damit einer hohen Zuverlässigkeit der Testskala sollten viele Aufgaben im mittleren Schwierigkeitsbereich zwischen 30 und 70 Prozent Lösungshäufigkeit liegen.

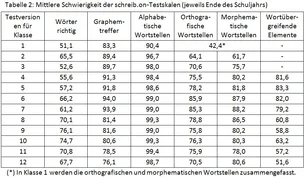

Richtig geschriebene Wörter: Der mittlere Anteil der Testpersonen, der die einzelnen Testwörter als Ganzes richtig schreibt, liegt Mitte der ersten Klasse noch bei knapp 40 Prozent und steigt dann rasch bis Ende Klasse 2 auf ca. 65 Prozent. Ab Klasse 3 steigen die Anforderungen der Testwörter deutlich an, sodass der mittlere Anteil der richtig geschriebenen Wörter zunächst auf gut 50 Prozent zurückgeht und dann allmählich auf ein Niveau von etwa 70 bis 75 Prozent ansteigt.

Graphemtreffer: Da die meisten Wortstellen relativ leicht richtig zu schreiben sind, liegen die Werte für die Schwierigkeit bei den Graphemtreffern naturgemäß deutlich höher. Die mittleren Werte reichen von ca. 80 Prozent in Klasse 1 bis ca. 95 Prozent in den Klassenstufen 6 und 7. Da in den Tests für Klasse 8 und höher bei den Graphempunkten auch die Fehlerwortstellen mitgerechnet werden, liegen die mittleren Werte für die Schwierigkeit hier bei ca. 80 Prozent.

Alphabetische Wortstellen: Bewertet man die geschriebenen Grapheme nach der alphabetischen Strategie, so ergeben sich schon ab Ende Klasse 1 durchschnittliche Werte für die Schwierigkeit von über 90 Prozent und ab der Klassenstufe 3 liegen die mittleren Schwierigkeitswerte für die alphabetische Strategie über 98 Prozent. Das bedeutet, dass die alphabetische Strategie in höheren Klassenstufen nur noch im schwachen Leistungsbereich differenziert.

Orthografische Strategie: Wortstellen, die nach der orthografischen Strategie bewertet werden, differenzieren in den Klassen 1 und 2 eher im oberen Leistungsbereich. Die mittleren Werte für die Schwierigkeiten liegen zunächst bei 30 Prozent (Mitte Klasse1) bis 64 Prozent (Ende Klasse 2). Ab Klasse 3 erreichen die mittleren Schwierigkeiten Werte von über 70 Prozent und steigen auf über 80 Prozent in Klasse 6.

Morphematische Strategie: Die Werte für die Schwierigkeit liegen für die morphematische Strategie (ab Klasse 2 als eigene Skala ausgewiesen) im Mittel etwas höher als für die orthografische Strategie. Sie steigen von gut 60 Prozent In Klasse 2 auf über 80 Prozent ab Klasse 4.

Wortübergreifende Zugriffsweisen: Ab Klasse 4 werden wortübergreifende Zugriffsweisen (v.a. Groß-/Kleinschreibung, Satzzeichen) als gesonderte Testskala ausgewiesen. Die durchschnittliche Schwierigkeit der wortübergreifenden Zugriffsweisen liegt in den Tests für Klassenstufe 4 bis 7 bei ca. 80 Prozent. In den Tests der Klassenstufe 8 und höher werden die wortübergreifenden Zugriffsweisen ausschließlich im Rahmen der Fehlersuchtexte erfasst, hier liegen die Werte für die Schwierigkeiten zwischen 52 und 63 Prozent.

Trennschärfe der einzelnen Testaufgaben

Als Trennschärfe wird die Korrelation eines Einzelitems mit der dazugehörigen Testskala (ohne das betreffende Item) bezeichnet. Je höher die Trennschärfe eines Items, desto stärker repräsentiert es die entsprechende Skala. Nach den einschlägigen Regeln der Testkonstruktion sollte die Trennschärfe einzelner Items möglichst über 0,30 liegen. Da die Trennschärfe u.a. von der Schwierigkeit abhängt, fällt die Trennschärfe bei mittelschweren Items (Lösungshäufigkeit zwischen 30 und 70 Prozent) in der Regel höher aus als bei extrem leichten oder extrem schwierigen Items (Lösungshäufigkeit kleiner bzw. größer als 10 bzw. 90 Prozent).

Richtig geschriebene Wörter: Bei den Testversionen für die Klassenstufen 1 bis 7 liegt die durchschnittliche Trennschärfe bei 0,42, bei den Einzelwörtern der Testversionen 8+ bei 0,39.

Da die meisten Wortstellen eine relativ hohe Lösungshäufigkeit aufweisen, sind der Trennschärfe der Graphemtreffer naturgemäß ziemlich enge Grenzen gesetzt. Bei den Graphemtreffern beträgt die Trennschärfe im Mittel über alle Testversionen 0,23. In den Testversionen für die erste Klasse, in denen die Graphemtreffer im Durchschnitt noch eine ca. 80-prozentige Lösungshäufigkeit aufweisen, liegt die Trennschärfe bei über 0,30.

Die Graphempunkte in den Fehlertexten, die sich auf fehlerhafte Wörter und fehlende Satzzeichen beziehen, weisen im Durchschnitt eine höhere Trennschärfe von ca. 0,43 auf.

Bei den besonders leichten Graphemstellen für die alphabetische Strategie beträgt die Trennschärfe im Durchschnitt lediglich 0,17.

Bei den meist schwierigeren Items für die orthografische undmorphematische Strategie betragen die durchschnittlichen Werte für die Trennschärfe 0,43 und 0,38.

Die Trennschärfe für die Einzelelemente der wortübergreifenden Zugriffsweisen liegt im Durchschnitt bei 0,28.

Zusammengefasst weisen demnach – abgesehen von Graphemtreffern und alphabetischen Elementen die Einzelitems der Testskalen für Einzelwörter sowie für die orthografische, morphematische und wortübergreifende Strategien eine befriedigend hohe bis gute Trennschärfe auf und sind für die Bildung von Testskalen geeignet. Bei Graphemtreffern und alphabetischen Elementen wird die relativ geringe mittlere Trennschärfe durch die große Anzahl der Items ausgeglichen, sodass auch hier stabile Testskalen vorliegen.

Zuverlässigkeit der Testskalen

Die Zuverlässigkeit (Reliabilität) ist ein Maß für seine Genauigkeit. Auf einer Skala von 0 bis 1 wird angegeben, wie genau der Test misst bzw. wie hoch sein Messfehleranteil ist. Bei einem Wert von 1,0 für die Reliabilität gibt es überhaupt keinen Messfehler, also auch keine Zufallsergebnisse. Bei einem Reliabilitätswert von 0,0 sind alle Testwertedifferenzen nur Messfehler, also bloßer Zufall. Nach den üblichen Praxisanforderungen gilt ein Reliabilitätswert von über 0,90 als exzellent, über 0,80 als gut und von mindestens 0,70 als noch akzeptabel für die Individualdiagnose. Als Methode für die Reliabilitätsanalyse von schreib.on wurde die sog. interne Konsistenz (Cronbachs Alpha) der Testwerte berechnet.

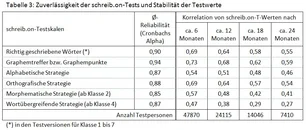

Wie die durchschnittlichen Werte für die einzelnen Testwerte von schreib.on in Tabelle 3 zeigen, ist die Zuverlässigkeit der meisten Testskalen exzellent bis gut. Die Schwankungen der Reliabilitätswerte zwischen den einzelnen Testversionen und Klassenstufen sind verhältnismäßig gering. Alle Testskalen übertreffen die Mindestanforderung von 0,70 als Reliabilitätswert deutlich.

Eine weitere Methode zur Überprüfung der Zuverlässigkeit ist die Retest-Korrelation, bei der durch eine zweimalige Testung mit demselben Test das Maß für die Stabilität der Testwerte ermittelt wird. Bei schreib.on konnten dafür die wiederholt durchgeführten Tests in LOS-Förderinstituten genutzt werden, da dort die Zuordnung der Testpersonen bei Testwiederholungen dokumentiert wird.

Allerdings wurden nicht die Testrohwerte, sondern die T-Werte bei den jeweils altersgemäßen Testversionen erfasst, und außerdem wurde bei ca. der Hälfte der Testpersonen nach 6 Monaten eine andere Testversion geschrieben. Dadurch wird die Höhe der Korrelationen durch Unterschiede in den Anforderungen zwischen den verschiedenen Testversionen beeinträchtigt. Daher sind die Werte nicht exakt als Retest-Korrelationen zu betrachten, sondern als wiederholte Erfassung des gleichen Testkonzepts mit altersangepassten Testaufgaben. Zudem ist zu berücksichtigen, dass die Klientel in den LOS-Instituten leistungsmäßig eingeschränkt ist und die geringere Leistungsstreuung die Höhe der Korrelationen ebenfalls beeinträchtigt.

Trotz dieser Einschränkungen belegen die Korrelationswerte in Tabelle 3 (rechte Hälfte) eine relativ hohe Stabilität der schreib.on-T-Werte, welche die Gültigkeit des schreib.on-Testkonzepts zur Erfassung orthografischer Kompetenzen über einen längeren Zeitraum unterstreichen. Am höchsten ist die Stabilität der T-Werte für die Graphemtreffer, deshalb sollten diese im Zweifelsfall zur Analyse der Lernentwicklung herangezogen werden.

Validität

Zur Gültigkeit von schreib.on liegen bisher nur wenige Daten vor. Allerdings ähnelt das Testkonzept stark dem Grundkonzept der HSP, das in etlichen Studien als sehr valide im Hinblick auf die Übereinstimmung mit Lehrerurteil und anderen Rechtschreibtests festgestellt wurde. Insofern kann davon ausgegangen werden, dass auch schreib.on nicht nur eine hohe inhaltliche Gültigkeit für die Erfassung der orthografischen Kompetenz aufweist, sondern auch eine hohe Übereinstimmung mit der Erfassung mit anderen diagnostische Methoden (z.B. Lehrereinschätzung) hat.

In einer Studie zum Vergleich zwischen schreib.on und HSP bei 122 Schülern mit Lese-Rechtschreib-Schwierigkeiten in den Klassenstufen 1 bis 10 wurden die Ergebnisse (T-Werte) beider Tests korreliert (Illek, Edith (2012): Qualitative und quantitative Unterschiede bzw. Gemeinsamkeiten der Diagnoseverfahren HSP (Hamburger Schreibprobe) und schreib.on zur Förderdiagnostik bei Lese-/Rechtschreibschwäche. PH Weingarten: Masterthesis, S. 66). Dabei ergaben sich relativ hohe Korrelationen von 0,81 bei den Graphemtreffern und 0,77 bei der Wortauswertung. Bei den Strategiewerten ergaben sich Korrelationen in mittlerer Höhe zwischen 0,53 (wortübergreifende Strategie) und 0,71 (orthografische Strategie). Die Abstufung in der Höhe der Korrelationen der einzelnen Subskalen entspricht der Abstufung bei der wiederholten Durchführung von schreib.on in Abständen von 6 oder mehr Monaten (siehe Tabelle 3).

Demnach stimmen schreib.on und HSP im Gesamtergebnis (repräsentiert durch Graphemtreffer und Wortauswertung) in hohem Maße überein, während sich bei den einzelnen Strategien weniger starke Übereinstimmungen zeigen. Dies liegt v.a. darin, dass bei schreib.on eine vollständige Auswertung aller strategiebezogenen Wortstellen erfolgt, während bei der HSP lediglich sog. Lupenstellen ausgewertet werden. Allein aufgrund der höheren Anzahl ausgewerteter Elemente dürften die schreib.on-Werte die Rechtschreibstrategien differenzierter beschreiben als die HSP.

Zur Übereinstimmung mit der Lehrereinschätzung liegt bisher nur eine kleinere Studie vor: In der LOS-Evaluationsstudie 2015/16 gaben 805 Eltern die Deutschnote ihrer Kinder an, die im LOS gefördert wurden und auch mit schreib.on getestet worden waren (May, Schneider & Oesterle 2017). Dabei ergab sich eine Korrelation von –0,26 zwischen Deutschnote und Testwerten (T-Werte Graphemtreffer). Die Korrelation ist statistisch hochsignifikant, fällt allerdings relativ gering aus, da die Rechtschreibleistung nach Angaben der Lehrer nur zu etwa 20 Prozent in die Deutschnote eingehen (vgl. Illek 2012, S. 84).

Zusammenfassung der Ergebnisse der Testanalyse

Das Testsystem schreib.on umfasst eine Serie von Rechtschreibtests für alle Alters- und Kompetenzstufen. Es weist eine hohe Differenzierungsfähigkeit in allen Leistungsbereichen auf und ist nicht nur für schwache Rechtschreiber, sondern auch für mittlere und hochkompetente Schreiber geeignet, das Niveau der Gesamtleistung und der spezifischen Rechtschreibstrategien zu bestimmen.

Die Testskalen von schreib.on sind insgesamt sehr zuverlässig und auch bei Testwiederholung hinreichend stabil. Damit ist schreib.on gut geeignet, sowohl die aktuelle Rechtschreibleistung als auch deren Verlauf in der Lernentwicklung zu erfassen und zuverlässig zu beschreiben.

Die hohe Übereinstimmung mit dem diagnostischen Grundkonzept der HSP wurde durch eine erste Studie bestätigt. Demnach ist schreib.on für die diagnostische Verwendung in pädagogischen und klinischen Bereichen mindestens so geeignet wie die HSP, wegen des erweiterten Anwendungskonzepts und der differenzierteren Auswertung sogar deutlich besser.

Neunormierung

Da schreib.on bisher hauptsächlich in LOS-Förderinstituten bei Schülern des unteren und mittleren Leistungsspektrums eingesetzt wurde, konnten die im System gesammelten Testdaten bisher nicht direkt für eine Neunormierung verwendet werden.

Die Bestimmung der Normverteilung orientierte sich daher an der Verteilung der in den Jahren 2012 bis 2015 erhobenen HSP-Werte, die für Deutschland repräsentativ sind.

Da zahlreiche Schreibwörter und Wortstellen sowohl in schreib.on als auch in der HSP vorkommen, wurden Summenwerte für die gemeinsamen Testteile für die Bildung vergleichbarer Leistungsverteilungen für HSP und schreib.on gebildet. Auf dieser Grundlage wurden die im DIDEON-System gespeicherten Testergebnisse so gewichtet, dass sie repräsentative Leistungsverteilungen für Deutschland ergeben.

Abgesehen von etwaigen Rundungs- und Schätzfehlern sind die neuen Normentabellen von schreib.on vergleichbar mit den aktuellen Normentabellen der HSP.

Bei der aktuellen Normierung wurden für alle Testversionen eigene Normentabellen berechnet, sodass Unterschiede in der Schwierigkeit zwischen den Paralleltests bei den Vergleichsnormen jetzt berücksichtigt werden.

(Bei der früheren Normierung von 2010 konnte für alle Paralleltests einer Klassenstufe jeweils nur eine einzige Normentabelle gebildet, weil es für einzelne Paralleltestversionen noch zu wenige Fälle gab.)